هوش مصنوعی جدید متا Llama 3.2 را بیشتر بشناسید.

دو ماه پس از عرضه آخرین مدل هوش مصنوعی بزرگ، متا با یک بهروزرسانی مهم به عرصه بازگشته است: معرفی اولین مدل منبع باز خود که قابلیت پردازش همزمان تصاویر و متن را دارد.

مدل جدید به نام Llama 3.2 به توسعهدهندگان این امکان را میدهد که برنامههای هوش مصنوعی پیشرفته تری طراحی کنند. این برنامهها میتوانند شامل اپلیکیشن های واقعیت افزودهای باشند که توانایی درک لحظهای از ویدیو را دارند، موتورهای جستجوی بصری که تصاویر را بر اساس محتوا مرتب میکنند، و ابزارهای تجزیه و تحلیل متنی که میتوانند متون طولانی را به راحتی خلاصه کنند.

متا اعلام کرده است که راه اندازی و استفاده از این مدل برای توسعهدهندگان بسیار ساده خواهد بود. احمد الداله، معاون هوش مصنوعی متا، در گفتوگویی با The Verge تأکید کرد که توسعه دهندگان تنها نیاز دارند تا این “چندوجهی جدید” را به پروژههای خود اضافه کرده و با آن تعامل داشته باشند.

در سال گذشته، دیگر شرکت های فعال در زمینه هوش مصنوعی مانند OpenAI و Google نیز مدل های چندوجهی مشابهی را معرفی کردهاند، بنابراین متا در تلاش است تا در این حوزه رقابت کند. افزودن قابلیت بینایی به این مدل نیز از اهمیت بالایی برخوردار است، به ویژه در راستای توسعه قابلیتهای هوش مصنوعی بر روی سخت افزارهایی مانند عینک های Ray-Ban Meta.

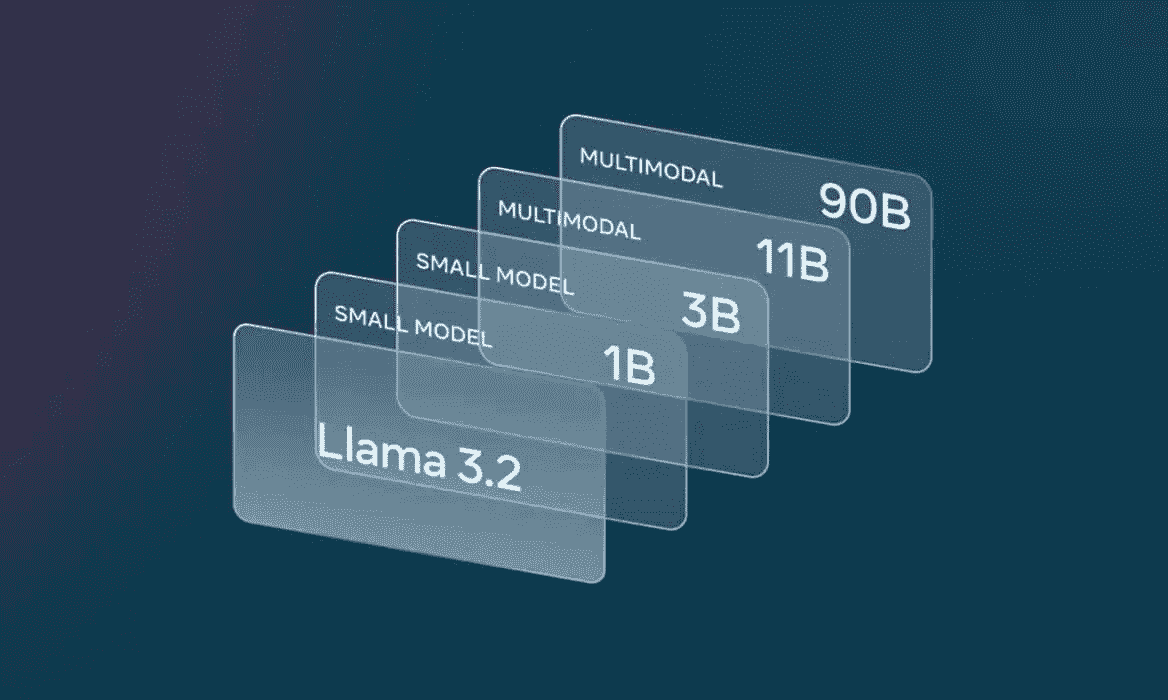

مدل Llama 3.2 شامل دو مدل بینایی با 11 میلیارد و 90 میلیارد پارامتر و همچنین دو مدل متنی با 1 میلیارد و 3 میلیارد پارامتر است. مدلهای کوچکتر به گونهای طراحی شدهاند که بر روی سختافزارهای Arm مانند کوالکام و مدیاتک کار کنند و متا امیدوار است که این مدلها در دستگاههای موبایل مورد استفاده قرار گیرند.

با این حال، هنوز جایی برای مدل Llama 3.1 که کمی قدیمیتر است وجود دارد. این مدل که در ماه جولای معرفی شد، شامل نسخهای با 405 میلیارد پارامتر است که به طور نظری توانایی بیشتری در تولید متن دارد.

منبع خبر: The Verge